Hace 75 años Alan Turing (el de la máquina Enigma, la de la peli) estableció una prueba conocida como el “test de Turing” que servía para evaluar que “tan humanas” eran las máquinas. Está diseñada para que mediante texto las computadoras logren convencer a un jurado humano (300 participantes, en este caso) que hablan con una “persona”.

La cuestión es que según los investigadores de la Universidad de California en San Diego GPT 4.5 logra confundirse con un humano en casi tres cuartas partes de las veces. El estudio utilizó una configuración de tres partes donde los jueces tuvieron que comparar una IA y un humano simultáneamente para una comparación directa durante conversaciones de cinco minutos.

Los jueces se basaron en la conversación informal y las señales emocionales más que en el conocimiento, y más del 60 % de las interacciones se centraron en actividades diarias y detalles personales. Ahí es donde GPT-4.5 logró una tasa de éxito del 73 % al engañar a jueces humanos cuando se les pidió que adoptaran una personalidad específica (en su prompt se le pidió actuar como un humano), superando significativamente a los humanos reales. Lo que de por sí es una paradoja, pero bueno, parece que aprendieron tanto de nosotros que son “más humanas”.

El modelo LLaMa-3.1-405B de Meta también pasó la prueba con una tasa de éxito del 56 %, mientras que los modelos de referencia como GPT-4o solo lograron alrededor del 20 %. Durante décadas el test fue la meta máxima de los investigadores, hoy parece que es algo sin valor. También es para tener en cuenta que estos modelos, que todavía tienen un costo de implementación elevado en un mercado de atención al cliente ya tienen un desempeño casi casi perfecto. No sería raro chatbots o mejores soluciones de voz tipo Monday de OpenAI en breve respondiendo la mayoría de las consultas sin que los usuarios sepan siquiera que hablan con una máquina.

La nueva familia de Mark

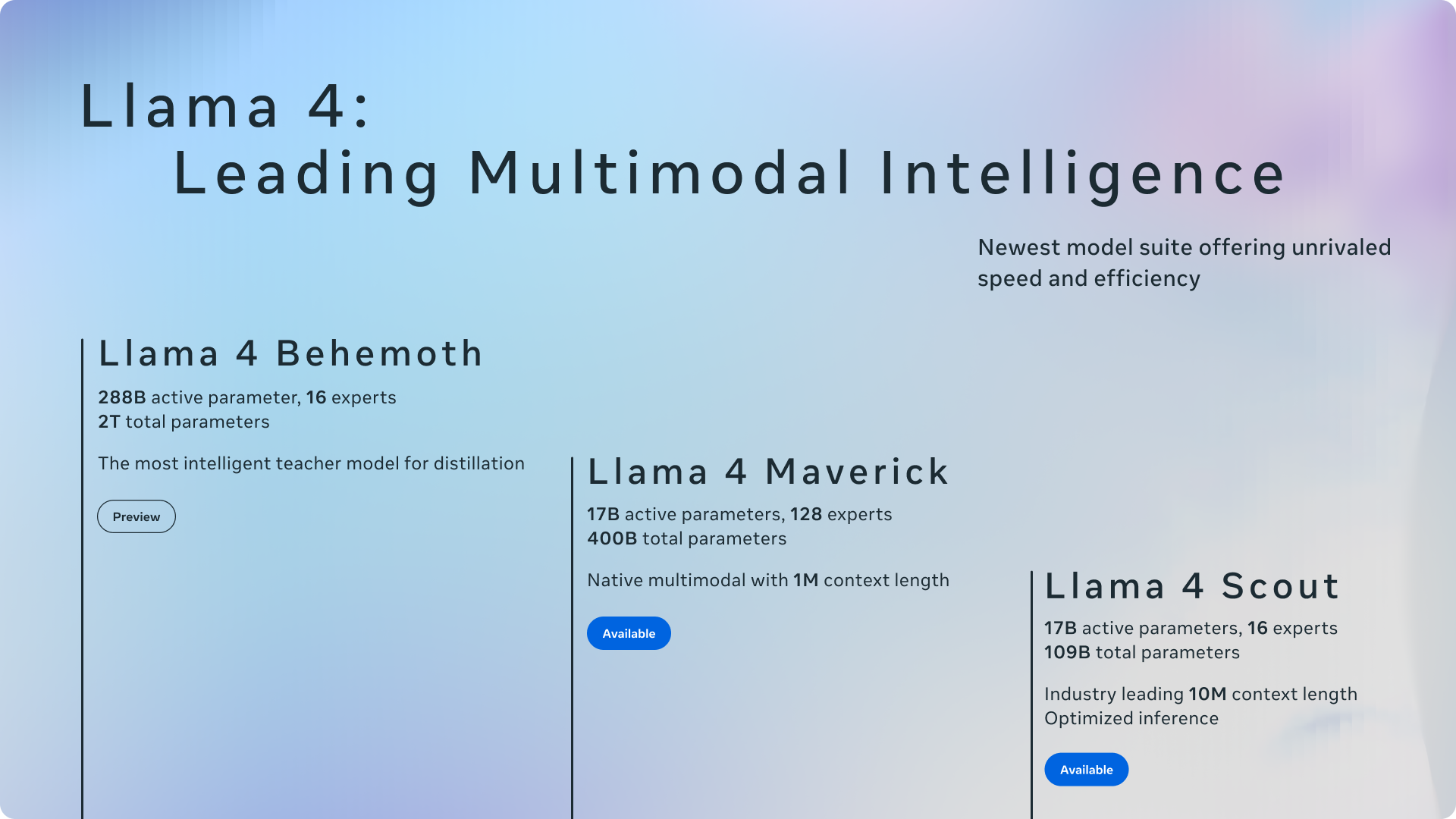

Meta, la empresa de Mark Zuckerberg, lanzó su nueva familia de modelos de código abierto Llama 4, presentando nuevos modelos y un contexto de 10 millones de tokens. ¿Qué significa? Que durante la “conversación” o el uso del modelo va a recordar mucho más que los modelos actuales. Esto es particularmente importante para trabajos largos donde manejamos muchos datos del momento.

En el uso cotidiano, como para editar un texto, escribir un mail de respuesta simple, o codificar una tarea sencilla no es relevante. Esa ventana está disponible en el modelo 109B Scout, que aseguran puede ejecutarse en una sola GPU H100, superando a Gemma 3 y Mistral 3 en los puntos de referencia. O sea, es un modelo “chiquito y liviano”, que compite en esa rama de los “mini”, los “baratos”.

Por su parte, el modelo mediano, el 400B Maverick ofrece una ventana de contexto un millón de tokens y según los datos de Meta supera a GPT-4o como a Gemini 2.0 Flash en puntos de referencia clave, siendo también más barato.

Por otra lado, la “bestia” de la familia fue solo presentado en forma de vista previa y se llama Behemoth, un modelo que señalan tendrá 2T de parámetros, aunque aún está en entrenamiento. Para “simplificar un poco”, 109B significa que el modelo tiene 109.000 millones de parámetros (que sería como su código interno y su entrenamiento), 400B es 400.000 millones (de ahí que ya no se pueda ejecutar en una sola placa GPU y el de 2T tiene 2 billones de parámetros o lo mismo en números: 2.000.000.000.000.

La explicación es para entender de qué estamos hablando y también para mostrar que si salen estos modelos abiertos, los que ya están van a tender a mejorar y como mínimo se van a esperar modelos aún mejores de las empresas privadas. Como cuando salió DeepSeek, que ya algunas cosas quedaron viejas y todos se tuvieron que acomodar.

Código abierto no es igual a gratis

Estoy viendo muchos posteos en este sentido y la verdad es que hay una fuerte confusión. Código abierto (también hay que ver las licencias) significa que podemos usarlo, reescribirlo o entrenarlo, usarlo para herramientas y sobre todo ver cómo está hecho.

Ahora bien, por más que no paguemos por el modelo sí vamos a pagar por el consumo. Me explico: si nosotros generamos una consulta esa consulta gasta electricidad y poder de computo. Eso hay que pagarlo, si está en la computadora propia, pero es un costo al fin y nunca es igual a cero. ¿Es más barato? Pues claro, si no tenemos en cuenta el costo de adquirir y mantener dicha computadora (o el dispositivo en el que usemos IA en el futuro). ¿Y las herramientas que dejan usar “gratis” sus servicios en internet? Siempre tengan en cuenta lo siguiente: cuando uno usa algo gratis en internet, el producto sos vos.

Y sobre este punto la empresa tecnológica Gartner hizo estimaciones: en Inteligencia Artificial generativa se gastó 364.900 millones de dólares en 2024 y se espera que se gasten 644.000 millones en 2025, un 76 % más en solo un año.

Así que, como suelo hacer en cada newsletter/posteo en el blog ¿Qué negocio con IA estás generando? Yo estoy terminando de testear un asistente que busca tendencias webs en tiempo real y está entrenado con mis parámetros de redacción SEO, con foco en Search y Discover. Si este párrafo no te hizo sentido o en su defecto te da mucha curiosidad contame por mail si te gustaría probar alguna de esas nuevas herramientas que hacemos con el equipo de Tres Barbas. También estamos pensando en hacer capacitaciones, pero va a depender de si ustedes están interesados o no.

Relámpago

- Amazon Kindle integró una nueva función de IA que presenta resúmenes de series de libros.

- Microsoft revivió Quake II y lo liberó de forma gratuita. La versión la diseñó su IA, llamada Muse. La “magia” es que el juego se está creando mientras lo jugas así que cada versión o partida debería ser distinta a la anterior. Podes probarlo acá.

- Google le sumó una nueva herramienta a NotebookLM: buscar en internet. Para la recomendación de fuentes, usa de contexto el material que ya está disponible en tu cuaderno.

- Sam Altman contó que cambiaron la estrategia en OpenAI, que originalmente iba a lanzar GPT-5, pero ahora parece que eso se va a demorar más de la cuenta por lo que saldrá antes al mercado o3 (la versión completa) y o4-mini previo a un GPT-5 “mucho mejor de lo esperado”.

- Midjourney lanzó su versión 7, la primera actualización importante de la compañía en un año. Esta supo liderar la generación de imágenes, pero el surgimiento de varios competidores (algunos de código abierto) y el nuevo generador de OpenAI la dejaron un poco relegada, al menos hasta ahora.

- Anthropic publicó su “Claude for Education”, un nivel de chatbot de IA para colegios y universidades, con un “Modo de aprendizaje” para estudiantes. Además, el director científico de la compañía, Jared Kaplan, indicó que en los próximos 6 meses saldrá Claude 4.

- Runway lanzó Gen-4 Turbo, una versión más rápida de su nuevo modelo de video IA que puede producir videos de 10 segundos en solo 30 segundos.

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Es algo súper íntimo y pueden no estar de acuerdo, pero creo que es una manera interesante de no solo decir “existe esto” si no “yo lo uso así” (o no).

Texto: ahora 4.5 y sino o3-mini (plan plus), Redacta.Pro (de pago). Unas herramientas nuevas que hice.

Video: Sora (plan Pro).

Audio: Elevenlabs (Pago), Adobe Audition (Pago) y NotebookLM (free).

Imágenes: GPT-4o (Pago) e Ideogram (gratis).

Programación: o3 mini (plan plus).

Buscador: Deep Research (OpenAI plus) y Perplexity (free).

Música: Suno.

Miscelánea: hace mucho no uso nada distinto.