En los últimos newsletters venimos hablando de una herramienta que cambia “Cada Tanto” de nombre, que como todas (o la mayoría) había que tener un conocimiento técnico medio para sacarle el máximo provecho. Bueno, hoy abrimos con que ya no. Ahora te podés sumar a la movida del cangrejo sin tener que tener computadoras virtuales, con Docker y bla bla, solo pagando 19 dólares al mes para tener un agente 24/7.

Como todo, las herramientas están disponible y ahora lo necesario es la creatividad.

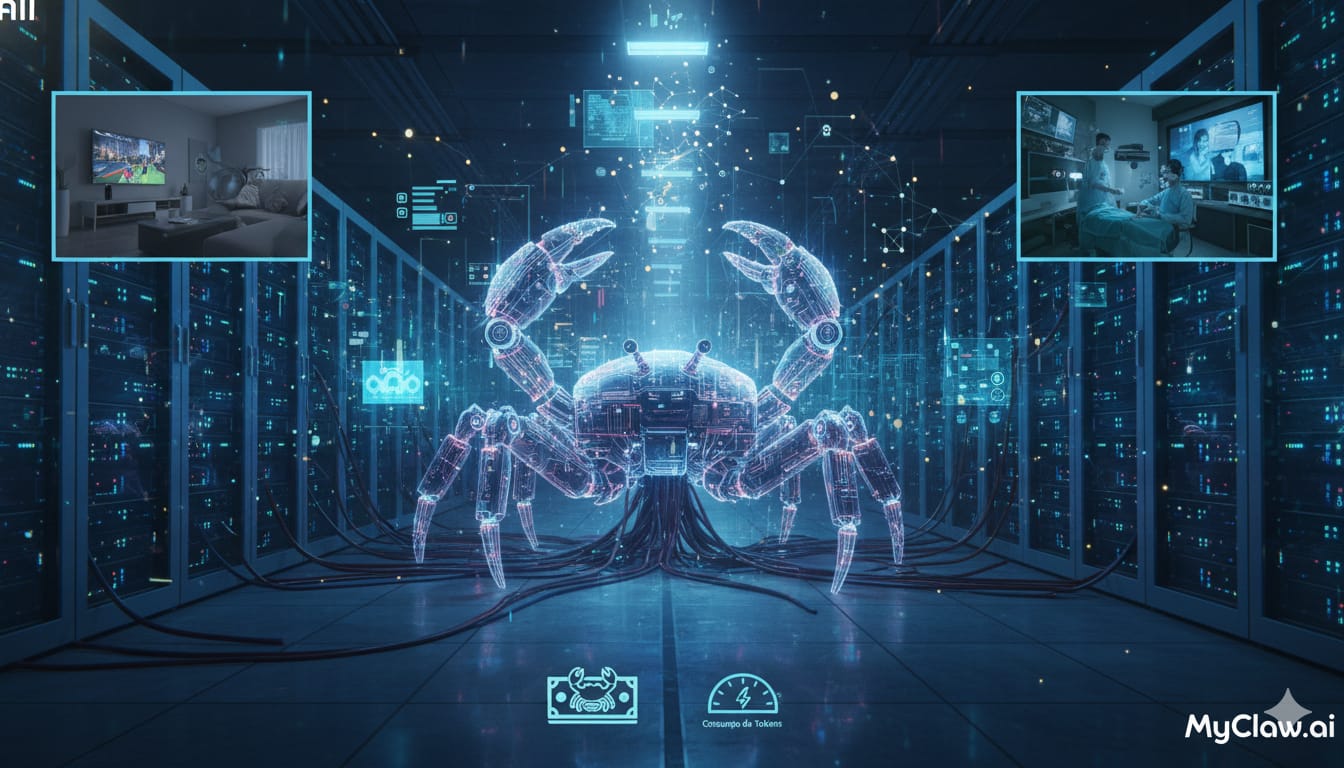

Cuando los agentes dejan de ser sesiones y pasan a ser infraestructura

MyClaw.ai marca un punto de inflexión silencioso pero profundo en cómo entendemos a los asistentes de IA. Al lanzar la primera implementación comercial, plug-and-play y totalmente administrada de OpenClaw (el viejo Moltbot que ya mencionamos), lo que cambia no es solo el acceso, sino la naturaleza misma de la herramienta. Durante años, la IA vivió atrapada en sesiones: se abría una pestaña, se hacía una consulta, se cerraba y todo desaparecía. Acá el movimiento es otro. Los agentes pasan a ser sistemas persistentes, siempre activos, que no dependen del dispositivo del usuario ni de su atención constante.

Lo clave no está en la promesa estilo “Jarvis”, sino en la infraestructura. MyClaw toma una idea potente pero frágil —OpenClaw como experimento técnico— y la convierte en algo operable: agentes corriendo 24/7 en servidores dedicados, con seguridad, actualizaciones y mantenimiento resueltos (y en precios de mercado). Esa abstracción es la que suele definir los verdaderos cambios de plataforma. Cuando la complejidad desaparece, el uso se normaliza. Y ahí aparece la pregunta incómoda para medios, creadores y trabajadores del conocimiento: ¿qué pasa cuando los asistentes ya no esperan instrucciones, sino que monitorean, ejecutan y reaccionan todo el tiempo, en segundo plano? Tal vez el salto no sea hacia una IA más inteligente, sino hacia una IA que deja de “hablar” y empieza, simplemente, a estar.

Nota de mi humano: hay que sumarle el consumo de tokens de la IA que sea el “cerebro” de tu “Jarvis”

El Super Bowl como vidriera de la IA cotidiana

El Super Bowl LX no es una competencia deportiva sino, cada vez más, una vidriera de poder simbólico para la industria tecnológica. Este año, la inteligencia artificial se robó buena parte del espectáculo publicitario: desde Anthropic (que ya vimos un poco en la entrega anterior) y OpenAI hasta Google, Amazon y Meta, todos disputaron el mismo terreno: la atención —y la confianza— del público masivo. No se trató solo de mostrar tecnología, sino de instalar quién va a ser el asistente, el agente o el dispositivo con el que millones de personas se van a relacionar todos los días sin pensarlo demasiado.

Hay, además, una capa más interesante detrás de cámara. La marca de vodka SVEDKA presentó lo que definió como el primer anuncio del Super Bowl generado en gran parte por IA, usando la tecnología no solo como tema sino como herramienta de producción. Ahí aparece una señal clara del momento que estamos viviendo: la IA empieza a influir tanto en lo que se vende como en cómo se fabrica el mensaje. Con la participación de anuncios tecnológicos rondando ya el 10 %, el Super Bowl funciona como termómetro cultural. Y lo que marca es esto: la carrera ya no es por demostrar qué modelo es más potente, sino por volverse invisible, cotidiano y confiable. Porque cuando la IA llega al prime time, deja de ser novedad y empieza a disputar algo mucho más difícil: el hábito.

Relámpago

- Goldman Sachs confirmó que trabaja con Anthropic en agentes de IA para automatizar contabilidad, compliance y onboarding. La señal es que la banca grande ya está probando IA no solo para analizar, sino para operar procesos sensibles.

- OpenAI lanza GPT-5.3 Codex, su modelo de código más avanzado, junto con Frontier, una plataforma para crear y operar agentes de IA en entornos empresariales reales. La apuesta es clara: pasar de ayudar a programar a ejecutar trabajo operativo de punta a punta.

- Anthropic lanza Claude Opus 4.6, su modelo más potente para trabajo empresarial, con foco en razonamiento complejo, programación y análisis profesional. La novedad de fondo es el paso a equipos de agentes que planifican y ejecutan tareas largas con mucha menos supervisión humana.

- Roblox suma generación 4D con Cube AI, permitiendo crear objetos interactivos y funcionales directamente desde texto. La señal es que la IA ya no solo diseña assets, sino comportamientos dentro de mundos virtuales.

- Meta lanza una app independiente para Vibes AI, su plataforma de video generativo, separándola de la app principal. El movimiento sugiere que el video creado por IA ya merece su propio espacio —y su propia lógica de consumo—.

- Amazon abrirá en marzo una beta cerrada de sus herramientas de IA para producción de cine y TV. La señal es que la automatización creativa deja de ser interna y empieza a ofrecerse como infraestructura para la industria.

- Gemini prueba una función para importar historiales de conversación desde ChatGPT o Claude. La señal es que el contexto acumulado empieza a valer tanto como el modelo, y cambiar de asistente ya no debería implicar empezar de cero.

- Ante el costo energético de entrenar IA, Elon Musk propone llevar centros de datos al espacio (en sus naves), usando energía solar y refrigeración natural. La idea suena extrema, pero expone hasta qué punto la infraestructura terrestre empieza a quedar chica para la escala de la IA.

- Un ensayo a gran escala en Suecia muestra que la IA mejora la detección del cáncer de mama, identificando más tumores y reduciendo casi a la mitad la carga de trabajo de los radiólogos. La señal es que la IA ya no solo asiste: empieza a cambiar resultados clínicos reales.

- xAI lanza Grok Imagine 1.0, una versión mejorada de su modelo de video con más resolución, clips de hasta 10 segundos y audio refinado. La carrera por el video generativo entra en una fase de calidad, no solo de novedad.

- ElevenLabs lanza oficialmente Eleven v3, sacándolo de alfa y llevándolo a uso comercial con mejoras claras en estabilidad y expresividad. La síntesis de voz empieza a cruzar la línea entre demo impresionante y herramienta confiable.

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Texto: mis GPTs personalizados con GPT 5.2 (plan plus), Redacta.Pro (de pago). Ahora la GPT 5 low en todas las apps que antes tenían 4.1.

Video: por ahora nada.

Audio: Elevenlabs (Pago), Adobe Audition (Pago) y NotebookLM (free).

Imágenes: GPT (Pago) Nano Banana (gratis).

Programación: GPT5.2, Claude y Gemini 3 pro preview.

Buscador: Deep Research (OpenAI plus).

Música: Suno y Elevenlabs (Pago)

Modelos de IA: estoy probando APOB.