Tengo un sentimiento que quiero compartir: con las gafas de Meta que empiezan a comercializarse en estas horas parece que el “futuro” llegó. No porque sea un “gran cambio”, ya habíamos visto algo parecido con Google en mayo que después medio quedó en el camino. Sino porque parece un salto en algo de uso diario y tiene ese sentimiento de “wow, esto es distinto”. Esa lógica que la magia y la buena tecnología comparten: asombran con algo difícil de explicar.

Y a nosotros (periodistas, comunicadores, gente de medios) nos abre un nuevo mundo de posibilidades: ¿cómo vamos a contarle el mundo a alguien que camina con sus lentes con realidad aumentada? Una pregunta que se viene haciendo desde hace años, pero que siempre terminaba en nada por la poca masividad o la incomodidad de los dispositivos. Pregunta que nos hicimos durante el fenómeno de Pokémon Go y que tenemos que hacernos ahora. Una pregunta que no se puede responder si pensamos con cabeza de molde, con la lógica de la edición impresa, con cabeza del último momento programado a las 12:00 en TV, con cabeza de clic como modelo de negocios, etc.

No es solo el tema lentes, no se me ocurre qué nuevo dispositivo vamos a tener en el futuro, pero sí que hay que pensar cómo interactuar con los humanos: algo que siempre fue nuestro objetivo y que a perdimos un poco de vista por intentar convencer solo a algoritmos y olvidarnos de lo importante. Porque hace años que se sigue la zanahoria de las métricas impulsadas por resultados y cualquier tipo de cambio en ellas eran (son) el terror de los SEO y de los modelos de negocios apoyados en métricas. Para no ir muy lejos, Pepe Cerezo publicó un interesante artículo hablando sobre los cambios en Discover, que hace foco en este problema.

En estos años, gracias a grandes maestros y maestras, aprendí que hay cosas que son elementales y que si las respetamos vamos a estar siempre en el lugar de las audiencias. Creo que pueden ser principios rectores para esta nueva discusión:

-Buenas historias.

-Información/contexto que sirva para entender el mundo.

-Contenido que haga que tu vida sea un poco mejor.

Me encantaría leer tu opinión y si querés las compartimos en el próximo Cada Tanto.

Lo que pasó entre un news y el otro

Como estuve bastante desaparecido, la semana pasada mandé un Cada Tanto y un día después hice un posteo en el blog, recopilando alguna data.

En resumen, hablamos un poco de un protocolo de compras para IA de Google, que da la posibilidad de decirle a una IA que puede comprar en tu nombre y darle una tarjeta de crédito, palabras más, palabras menos.

También sobre nuevas restricciones de uso de IA para adolescentes, herramientas de YouTube para creadores de videos, avances en robótica de la mano del creador de Alibaba.

Resumen del día

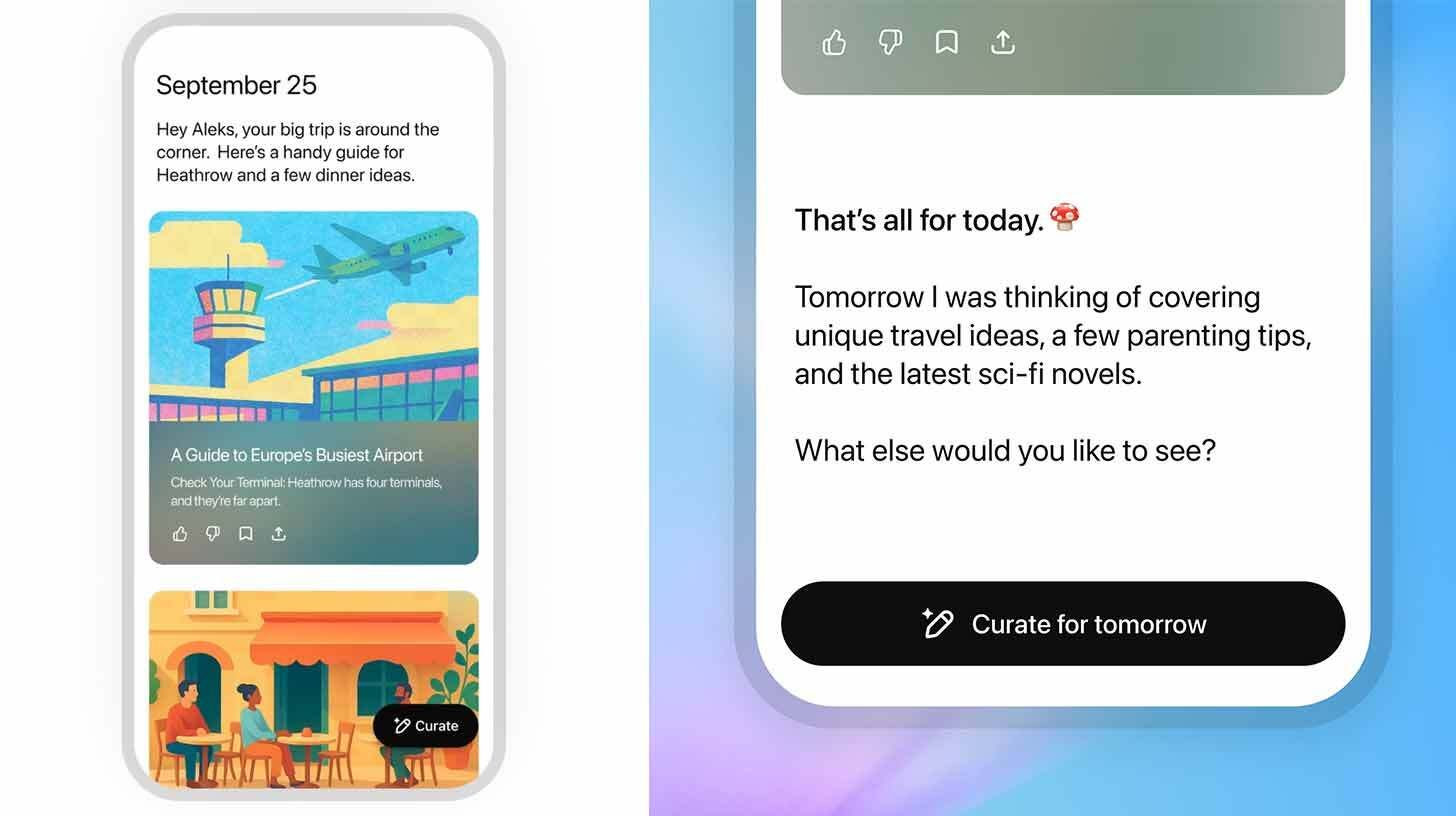

En fase de prueba OpenAI lanzó Pulse, un resumen del día según los intereses de sus usuarios que durante la noche genera resúmenes y los muestra en forma de tarjetas.

“Cada noche, sintetiza información de tu memoria, historial de chat y comentarios directos para descubrir qué es lo más relevante para ti y, al día siguiente, te ofrece actualizaciones personalizadas y específicas. Estas pueden ser, por ejemplo, seguimiento de temas que discutes con frecuencia, ideas para una cena rápida y saludable para preparar en casa esa noche o próximos pasos hacia un objetivo a largo plazo, como entrenar para un triatlón”.

Como idea parece interesante, por lo visto también se puede conectar a calendario, mail, etc. Si todavía no tienen esas conexiones, yo esperaría un poco más. Está demostrado que es bastante fácil acceder a la memoria de tus conversaciones o al control de tus cuentas dando prompts ocultos en mails o en invitaciones a eventos en Calendar. Por lo que es recomendable tener prudencia en su uso.

Como Wall-E

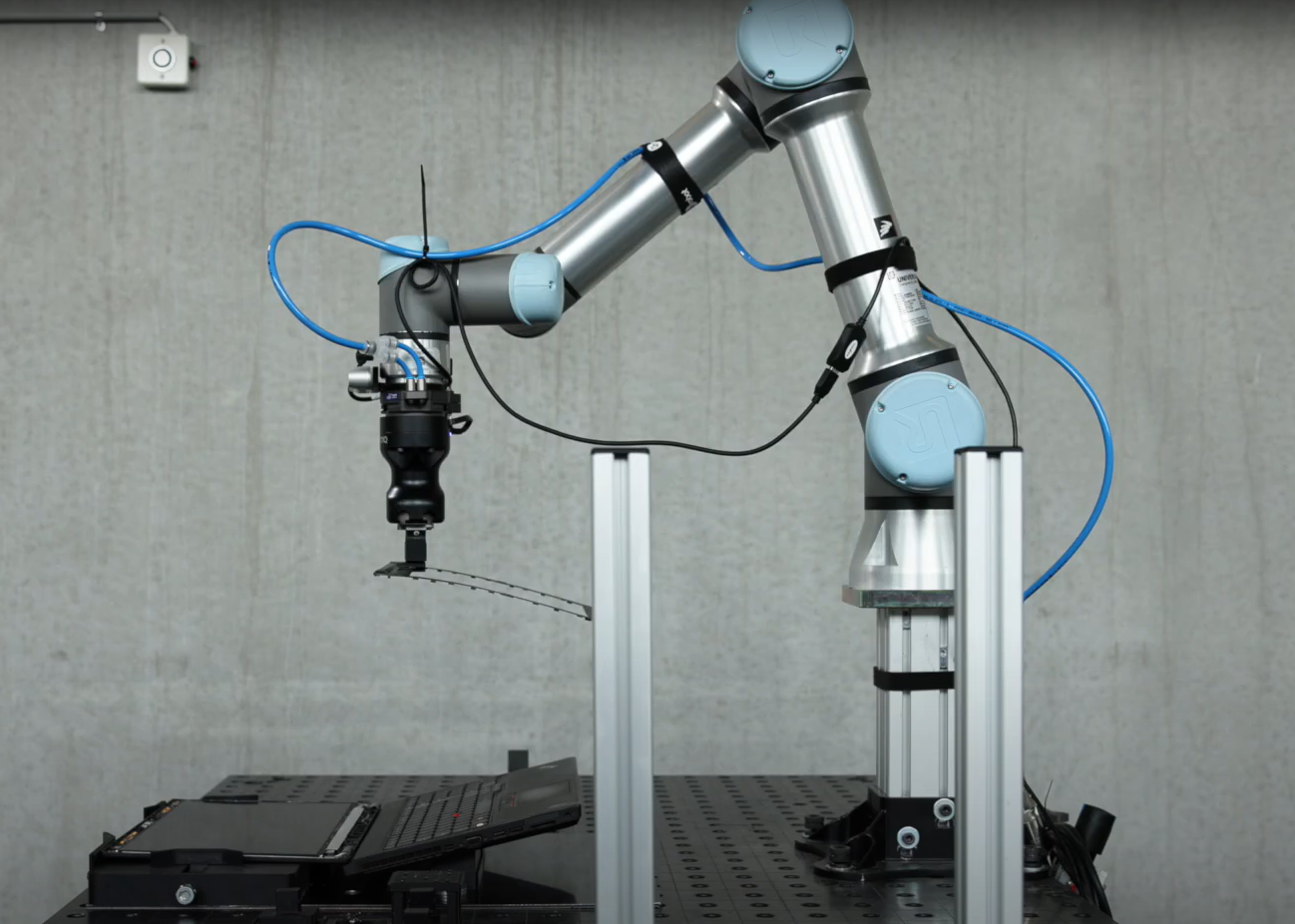

¿Esa computadora rota se puede arreglar o es basura? Esa pregunta de base es la del equipo del Instituto Tecnológico Danés que entrenó a un robot con IA capaz de reparar notebooks y colaborar con la reducción de la basura tecnológica.

El robot actualmente es un brazo, una cámara y una caja de herramientas, que está enfocado en cambiar pantallas rotas por nuevas y revivir los equipos. Una tarea tediosa y que en algunos países no es nada rentable.

Se lo puede ver en acción en este video. Por ahora solo es capaz de trabajar con ciertos modelos (los que está entrenado) pero esto es como todo, darle un poco de tiempo y va a seguir avanzando. Según el equipo, una notebook rota y triturada, vendiendo sus materiales vale unos 10 euros, cuando reparada se puede comercializar hasta en 200.

Relámpago

- Relación abierta: Microsoft agregó los modelos Claude de Anthropic a Microsoft 365 Copilot, dejando de lado la exclusividad de OpenAI.

- Por lo visto, Google fusionará ChromeOS con Android en 2026 para llevar Gemini AI a pantallas más grandes.

- Antiguos desarrolladores de NotebookLM lanzaron Hume, una herramienta que busca “limpiar el ruido” de las noticias y los medios con IA y hace, además, lo mismo que Pulse (lo que vimos más arriba). Se puede probar en este enlace.

- Ya está en la calle Qwen3-Max, el mayor modelo de Alibaba, que dicen puede realizar tareas de codificación y de agente con una intervención humana mínima.

- Google presentó Mixboard, su Pinterest experimental impulsado con IA, para crear tableros con ideas de diseño.

- ¿Un Duolingo sobre la Biblia? Esa es la idea de Manna, una herramienta impulsada con IA para que lleves tu estudio bíblico al siguiente nivel (?). Más allá de lo pintoresco del asunto, es una muestra más de todo lo que se puede hacer con IA, ganas y algo de presupuesto.

- Sabores IA: Magnum (la de los helados) sumó a su equipo de I+D la tecnología de la chilena NotCo para “reducir calorías, sustituir lácteos por vegetales y crear el próximo sabor viral”, según reporta Reuters. No sería la primera vez que la empresa chilena trabaja en el campo: crearon los macarrones con queso y la mayonesa de origen vegetal de Kraft Heinz.

- La actriz de inteligencia artificial, Tilly Norwood, de la empresa Xicoia, está en negociaciones con varias empresas de talentos de Hollywood, lo que claramente está generando mucho ruido en el ambiente.

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Es algo súper íntimo y pueden no estar de acuerdo, pero creo que es una manera interesante de no solo decir “existe esto” si no “yo lo uso así” (o no).

Texto: mis GPTs personalizados con GPT 5 (plan plus), Redacta.Pro (de pago). Para aplicaciones (o sea con API) 4.1 las de respuesta rápida o GPT 5 mini las “normales”.

Video: por ahora nada.

Audio: Elevenlabs (Pago), Adobe Audition (Pago) y NotebookLM (free).

Imágenes: GPT (Pago) Nano Banana (gratis).

Programación: 99 % con GPT5, pero cuando se complica uso alguna otra, aunque cada vez menos.

Buscador: Deep Research (OpenAI plus).

Música: Suno.