Voy aprovechar que es Viernes Santo para extenderme un poco más en algunas noticias que salieron esta semana y que vi confundió bastante a muchos. Pero antes de arrancar, retomo un poco las ideas de la semana pasada: hablamos de IAs que ya es difícil de distinguir en una conversación si son o no máquinas, sobre que Meta lanzó nuevos modelos de “código abierto” y debatimos un poco sobre este tema. Obvio que pueden mandarme por mail su visión sobre este tema o los que trataré hoy, así que escriban tranquilos/as.

Los usuarios avanzados pueden saltar la primera parte que será de contexto y de explicación, aunque un repaso nunca está de más. Trataré de a cada idea compleja darle un ejemplo de aplicación real.

El lío de OpenAI con los nombres

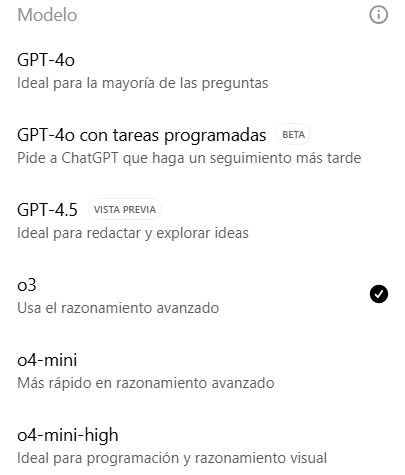

La noticia es que la familia de modelos de OpenAI se agrandó y lanzó desde el último newsletter GPT 4.1, o3 y o4-mini, que conviven con la última versión de GPT-4o y GPT-4.5. Dejando el panel de los usuarios una serie de nombres no apta para disléxicos.

Y lo primero que viene a la mente es: ¿No dijiste 4.1, Mauro? y lo segundo ¿Qué significa todo esto y cómo puedo seguir haciendo mis imágenes tipo personajes de Marvel o Estudio Ghibli?

Vayamos por partes. Hay mucha información sobre los modelos de IAs y desarrollos en las notas del blog (en este enlace) pero para simplificar y así todos estamos en tema: hay dos grandes líneas en el desarrollo de los modelos de inteligencia artificial la de razonamiento y las de no razonamiento (que serían las clásicas).

Los modelos de razonamiento suelen dar mejores resultados, pero son más caros en esencia porque le dan “más tiempo para pensar” a los modelos de inteligencia artificial (o sea gastan más electricidad y computo), por lo tanto pueden dividir las tareas complejas en subtareas más sencillas, buscar opciones de respuestas, probar algunas hipótesis y luego dar una respuesta, a diferencia de los modelos clásicos que prácticamente escupen una respuesta.

4.1, mini y nano

Lo primero que pasó es que OpenAI anunció 4.1, un modelo que solo está disponible para las APIs (o sea para usar en aplicaciones que desarrollemos nosotros por ejemplo) con muy buen rendimiento en codificación, mejores costos por millón de tokens y una ventana de contexto bastante grande, algo así como 3.500 páginas de texto, unas 8 veces más que los límites de 4o para API.

Entonces si están desarrollando una aplicación para corrección de noticias, se pueden pasar más información por prompt y pagar menos por ese proceso, lo que siempre es bueno. Nosotros estamos estudiando una nueva función para Redacta.Pro que usará esa función, además de dar mejores resultados por un mejor modelo.

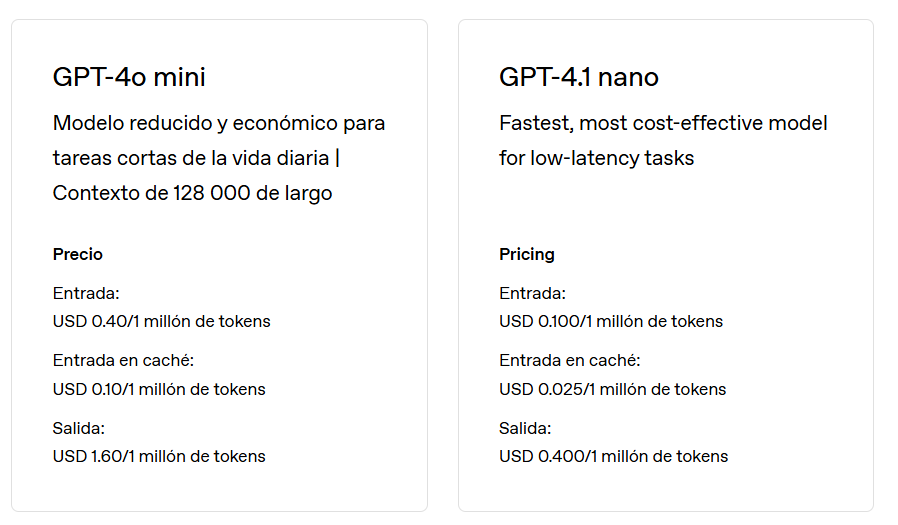

Pero el 4.1 no viene solo, sino que viene con dos hermanos menores que dan respuestas no tan buenas pero sí mejores a las de sus predecesores y mucho más barato. Miren esta comparación, para que tengan un ejemplo.

Son precios muy marginales, lo que es excelente si quieren por ejemplo un chatbot para su medio o empresa que responda con calidad conectado a una base de datos, pueda agendar citas y lo que se les ocurra. Una conversación (hay muchas variables, pero les comento una que tenemos estudiada) de un chatbot que se dedica a mostrar propiedades para alquiler y reservar turnos usa entre 30 y 50 mil tokens por conversación. Pongamos 50 para hacer más fáciles las cuentas, con 4o mini esa conversación sale en promedio 5 centavos de dólar (en valor OpenAI) pero con 4.1 nano sería menos de un centavo. Y estoy hablando de una conversación de 20 mensajes ida y vuelta, base de datos, etc…

¿Y los o3 y o4?

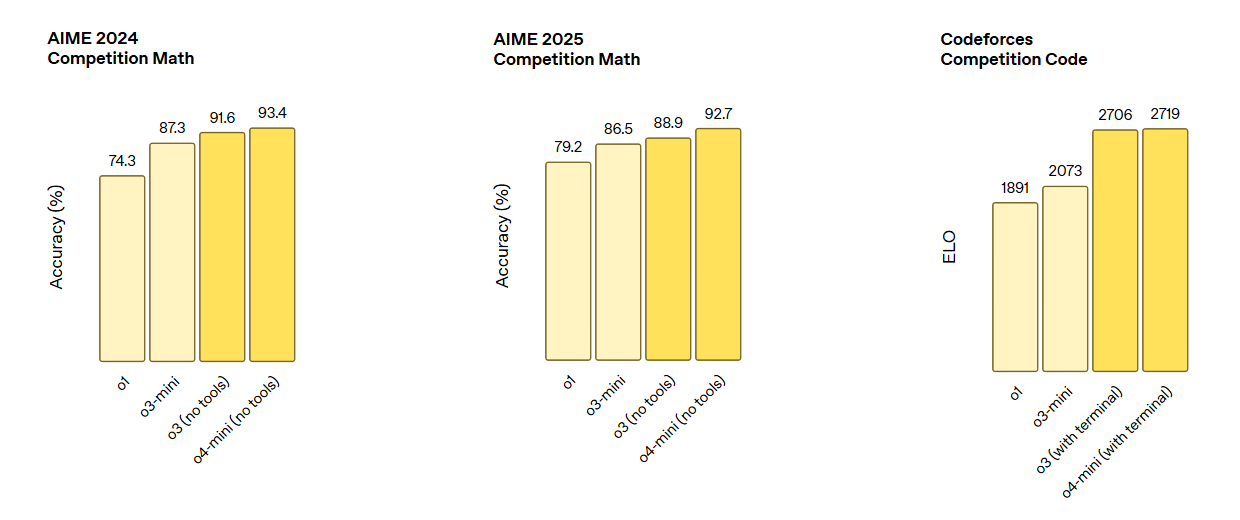

Acá entran los otros modelos, los que iniciaron con o1 y siguieron hace un par de meses con los o3 mini (no hay o2, pero no porque no haya salido, sino por el tema de los derechos de autor al ser una marca de o1 se saltó a o3). Se trata de o3 (versión completa) y o4-mini, que son las herramientas más poderosas de la empresa y que tienen acceso a todos los recursos disponibles, como la memoria y la capacidad de “pensar con imágenes”.

o3 es el hermano grande, el mejor modelo público hasta la fecha y según el artículo de lanzamiento con 20 % menos errores en tareas del mundo real que o1, mientras que o4 mini es “muy bueno, pero no tanto” y sí muuuucho más barato (aunque no tanto como DeepSeek para desplegarlo en una herramienta, que por ejemplo busque contexto para enlaces de sus notas o verifique fuentes).

Como un extra, los de OpenAI lanzaron una herramienta de código abierto llamada Codex CLI para asistir al programación con estos nuevos modelos de razonamiento. Seguramente la semana que viene cuente alguna de las experiencias con estos nuevos modelos, cuando sean integrados a las herramientas que tenemos en producción en Tres Barbas.

¿Y lo de la red social?

Ah, cierto, pasa que esto me suena bastante a chamuyo, pero lo comento igual. ¿Vieron que Meta tiene su IA? ¿y que Musk tiene X y su IA? Bueno, hace un tiempo Sam Altman (el capo de OpenAI) dijo que quizá ellos deberían tener una red social en respuesta a que Meta en febrero estaba buscando tener una app de IA como la de OpenAI (qué lío de nombres).

La cuestión es que el medio The Verge informó que la OpenAI está trabajando internamente en un feed social con base en ChatGPT, apoyados por el éxito que tuvieron cuando se puso de moda allá y hace tiempo (dos semanas) lo de hacer imágenes de todo tipo. El tema no es solo si hay una red social o no, sino que de existir va a ser una excelente forma de recopilar datos para entrenar nuevos modelos.

Generar videos

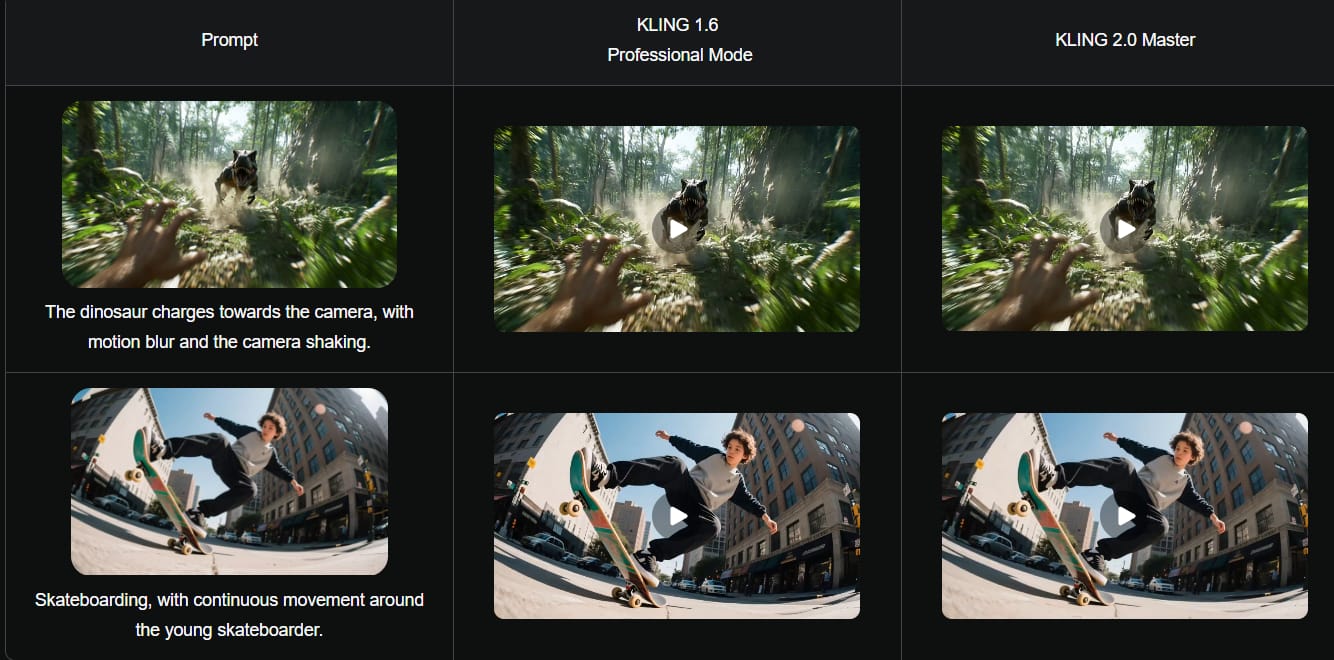

Vamos a dejar un poco de lado a OpenAI (por un rato) y vayamos a mirar en qué andan los chinos. La starup Kling AI lanzó una actualización masiva de su herramienta con KLING 2.0 Master para la generación de video y KOLORS 2.0 para la creación de imágenes, con mayor capacidad de entender (y seguir) los prompts, resultados más realistas y capacidad de editar los resultados (algo muy deseado).

Los resultados son bastante buenos, posiblemente los mejores del mercado en el momento y el modelo de imágenes maneja unos 60 estilos y es más consistente con los detalles, algo que parece se está volviendo un estándar en la industria.

Además según se reporta en cuanto a convertir imágenes a video logró un éxito del 182 %, contra el 178 % de Veo 2 (el modelo de Google) y Gen-4 de Runway. Las 3 empresas son las que hoy están liderando el mercado del video con inteligencia artificial. ¿Usas alguna de estas? ¿Para qué? Contame tus experiencias por mail.

Gemini con Veo2

Ya que estamos en este tema, los usuarios de Gemini Advanced van a poder probar Veo 2 en videos de hasta 8 segundos con su suscripción, así que a sacarle el jugo a la herramienta (que es muy buena y hasta hace unos días era la mejor).

¿Hablar con los delfines? Sí, por qué no

Google anunció DolphinGemma, una IA entrenada para entender los patrones de los sonidos de los delfines y servir como “traductor”. La idea es que usando los teléfonos de Google (Pixel) los investigadores no solo puedan entender, sino también “hablar” con los delfines. Es el primer paso para comunicarse con todas las especies que tengan la capacidad de un lenguaje más o menos articulado.

Se puede saber más sobre el proyecto en su sitio web oficial.

Relámpago

- Anthropic está dando pasos para convertir su modelo de IA en un asistente que sea más atractivo que un simple chatbot (personalmente creo que las herramientas integradas son el camino para el uso profesional, pero no para un uso casual o una respuesta rápida).

- Más o menos en el mismo sentido, Grok (la IA de X) lanzó Grok Studio, su nueva función para crear documentos y aplicaciones.

- Microsoft dotó a Copilot de la capacidad de “uso de la computadora” dentro de Copilot Studio, lo que permite a los usuarios crear sus propios agentes que puedan operar aplicaciones o sitios web directamente.

- Un lenguaje para unirlos a todos: Google, OpenAI y Anthropic trabajan en conjunto para el desarrollo de un Protocolo de Contexto de Modelo (MCP) de código abierto que unifique parámetros. En este caso, el MCP lo desarrolló Anthropic y Google ya lo adoptó, mientras que OpenAI mejoró las capacidades de sus modelos para entenderlo, aunque la información acá no es muy clara.

- Lo que sí es claro que ahora todas las cuentas de GPT tienen una “Biblioteca” donde se puede acceder rápido a todas las imágenes creadas.

- ByteDance presentó su modelo Seaweed, muy chiquito y optimizado que hace frente a los modelos comerciales (pero no los de punta) de las empresas Google, Kling y Runway. Acá la noticia no es el resultado, sino lo liviano y barato.

- Nexflix está probando un motor de búsqueda que evalua sentimientos y recomienda películas o series, con ChatGPT de fondo. Actualmente está disponible como prueba en Australia y Nueva Zelanda, pero la idea es que puedas buscar “una película romántica liviana que me haga reír y llorar” y que la respuesta sea razonable.

- Canva se actualizó con Visual Suite 2.0 integrando nuevas funciones de IA a sus herramientas de diseño, el amigo/enemigo de los diseñadores avanza en mejorar la productividad. Y no es para menos, porque la herramienta la usan 230 millones de personas por mes. Tiene una herramienta de sugerencia de diseño, otra de leer hojas de calculo y poder crear infografías y hasta una herramienta sencilla de codificación.

- Safe Superintelligence INC., una empresa cofundada por un ex OpenAI logró juntar 2 mil millones de dólares para financiar sus investigaciones buscando crear una “superinteligencia” que supere a los humanos. Algo así como lo que buscan todos, pero acá sin irse por productos comerciales durante el camino.

- Un estudio médico realizado por investigadores suizos del Hospital Universitario de Lausana demostró que la IA puede diagnosticar la tuberculosis pulmonar con mayor precisión que los expertos humanos, superando los estándares de la OMS para las pruebas de tuberculosis sin esputo.

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Es algo súper íntimo y pueden no estar de acuerdo, pero creo que es una manera interesante de no solo decir “existe esto” si no “yo lo uso así” (o no).

Texto: ahora 4.5 y sino o3 (plan plus), Redacta.Pro (de pago). Para aplicaciones (o sea con API) 4o-mini y algunas con 4o.

Video: Sora (plan Pro)

Audio: Elevenlabs (Pago), Adobe Audition (Pago) y NotebookLM (free).

Imágenes: GPT-4o (Pago) e Ideogram (gratis).

Programación: o3 (plan plus).

Buscador: Deep Research (OpenAI plus) y Perplexity (free).

Música: Suno.

Miscelánea: hace mucho no uso nada distinto.