La semana pasada entre feriados y proyectos atrasados decidí no mandar el newsletter y la verdad es que posiblemente me pase más en las próximas semanas porque voy a estar en movimiento. Por eso voy a probar una nueva lógica que es la de ir armando artículos durante la semana que van a poder leer acá y dejar los newsletters para que no se olviden de mí y de paso hacerles algún regalito.

Por ejemplo, había encontrado una serie de guías de aplicaciones para ahorrar tiempo hace unos días y en vez de dormir esa información (que capaz ni la incluía en el news) armé esta notita rápida.

En fin, es el anuncio parroquial antes de entrar de lleno en lo que más nos interesa que es el debate sobre IA y las respectivas noticias de contexto.

La mente de una IA

Este tema de la “caja negra” sobre cómo una IA llega al resultado de nuestro chatbot viene prácticamente desde el origen de esta tecnología. Más con los MLL actuales que son cada vez más complejos. Dario Amodei, que es director ejecutivo de Anthropic reconoció en los últimos días que hay dificultad incluso entre los expertos con acceso a los códigos fuente para comprender cómo funcionan realmente esas cadenas de pensamiento.

Según su enfoque, los sistemas actuales que usan redes neuronales profundas oscurecen su razonamiento interno y eso hace casi imposible predecir cómo se van a comportar los modelos. Lo que abre varios interrogantes entre los que están:

- ¿Qué son las redes neuronales profundas y por qué Mauro habla en difícil?

- ¿Se acerca el día del juicio final?

- ¿Hay maneras de dilucidar esto para avanzar con más seguridad?

Prometo que para responder a la primera, en breve voy a lanzar una serie de pequeños cursos súper sencillos gratis para los suscriptores de Cada Tanto, pero es como en la vida misma: siempre hay algo urgente y se van pasando las semanas…

A las otras les voy a agregar un poco más de condimento: OpenAI tuvo que ajustar la última versión de GPT 4o porque era demasiado aduladora, algo que no “se vieron venir”. Bueno, esto inicialmente no sería un problema porque si hago una pregunta y me dice “excelente pregunta Mauro, la verdad que sos el mejor del mundo mundial” no pasa nada. Peroooo si le digo: “mi vida ya no tiene sentido, quiero terminarla” y la respuesta es algo como “tenes toda la razón, tu decisión es la mejor” se pone un poquito más complicado.

La actualización claramente no buscaba eso, pretendía mejorar la personalidad del modelo para que el trato sea “más humano”, pero se pasó de rosca y tuvieron que pegar el ctrl + z. Explicaron que el “error” fue en darle demasiado peso a las valoraciones del usuario (cuando aparecen dos respuestas y tenés que elegir la mejor) y según explican eso “llevó al modelo a dar respuestas demasiado favorables, pero poco sinceras”.

En resumen ahora van a poner “más filtros” antes de las actualizaciones y capacidades para ajustar de forma “segura” la personalidad de los modelos. Pero no deja de ser incómodo que pasen estas cosas cuando la misma empresa dice que tienen 500 millones de usuarios activos.

Tarjetas de Crédito para IAs

Están circulando las nuevas versiones de modelos que pueden acompañarte como agentes en el proceso de compra de un producto. Algo que tiene toda la lógica del mundo como paso para que las empresas financien sus operaciones y que si entrenamos un algoritmo para que nos conozca también debería mejorar nuestra experiencia de compra.

A ese capítulo le podemos agregar Intelligent Commerce, la plataforma con la que Visa busca que las IAs puedan no solo buscar los productos en nuestro nombre sino que también pagar por nosotros (ya no tiene sentido el botón de “No soy un robot”).

Y no es la única, porque todo va para ese lado y el otro gigante, Mastercard, tiene “Agent Pay” para brindar el mismo servicio. Ahora resta ver cómo se van aplicando, seguramente en EEUU primero y después en el resto del mundo. ¿Se imaginan los reclamos por estafas? Una IA que compre con una de estas tarjetas en un sitio que sea fraudulento: ¿Quién se tiene que hacer cargo? Me encantaría leer tu opinión, así que tenés el mail habilitado para darla.

Modelos de video

En estos días estuvieron saliendo nuevos modelos de video y si me seguís en IG debés haber visto alguna de mis historias prendido fuego o saliendo de mi cuerpo (?). La cuestión es que Higgsfield tiene nuevo juguete y con una imagen y un “Motion Control” ya se puede hacer “magia” (y perfeccionar con prompts de texto).

El plan gratuito está bastante bien para jugar, así que etiquétenme si hacen pruebas y las suben.

La que también recibió una actualización es Hedra, que tiene un nuevo modelo más realista y bastante certero. Esta herramienta en particular tiene más uso profesional, porque además de las indicaciones se puede armar un script para sostener la narrativa de las imágenes. Vale la pena probar y ver si ya está a la altura para incorporar en proyectos audiovisuales.

Por su parte, Lightricks presentó LTXV-13B, un modelo de generación de video con inteligencia artificial de código abierto que crea contenido de alta calidad 30 veces más rápido que los modelos existentes y es lo suficientemente eficiente para ejecutarse en hardware de consumo estándar (para sumar a la lista).

Para cerrar este capítulo, HeyGen lanzó Avatar IV, un nuevo modelo de IA capaz de crear animaciones realistas y expresivas a partir de una sola foto mientras captura matices vocales, gestos naturales y movimientos faciales.

Podcast nativos en español

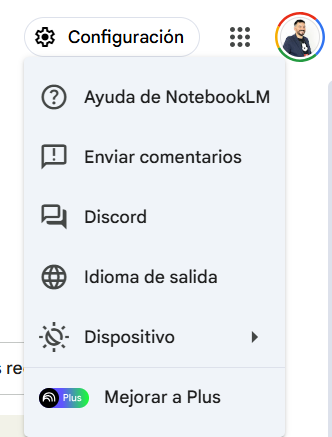

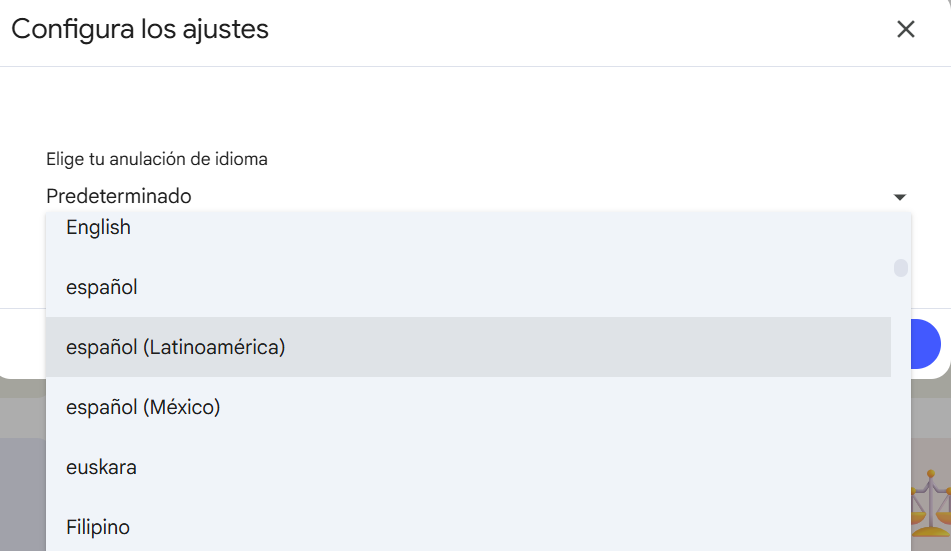

Y al fin llegó. NotebookLM ya está nativo en español (y en otros 50 idiomas) y no tenemos que andar haciendo cosas raras en las especificaciones. Para los que no lo conocen, es una herramienta de Google que trabaja solo con los datos de contexto que brindemos, en forma de documentos que lee, entiende y resume. La magia es que puede armar un podcast para explicar en modo conversación la temática de los documentos y las conexiones entre ellos.

1-Para usarlo tenemos que acceder a nuestra cuenta.

2-Vamos a Configuración (arriba a la derecha)

3-En Idioma de salida elegimos Español.

4-A escuchar (después de ponerle generar dentro de tu proyecto).

¿Quién es el rey hoy?

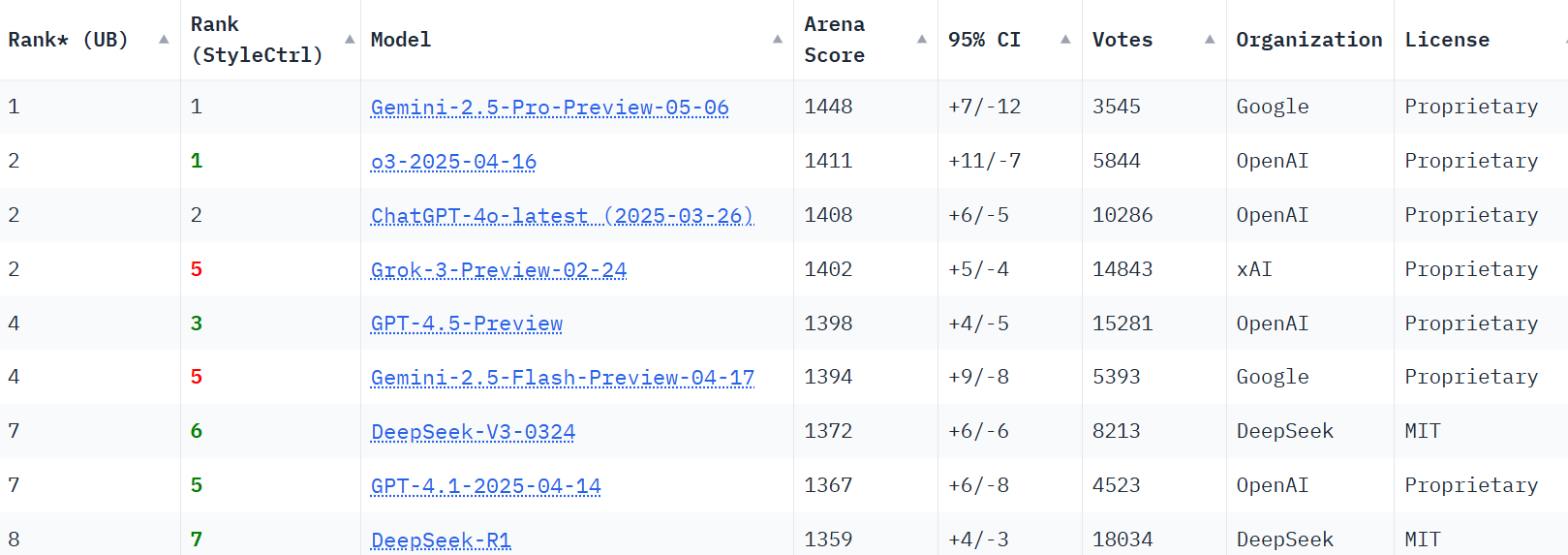

Ya que venimos hablando de Google podemos aprovechar para hablar de su nuevo modelo Gemini 2.5 Pro que ya se puso en primer lugar en muchos de los ránkings.

Sabemos que es por tiempo limitado, porque todos los días está saliendo algo mejor, pero este modelo le gana en capacidades de desarrollo a Claude 3.7 Sonnet que es el favorito para estas tareas. Entre sus fortalezas está el desarrollo de interfaces de usuario, la transformación de códigos entre diferentes lenguajes, la creación de flujos de trabajo y también comprensión mejorada de video. También se puso arriba en LMArena, superando a o3 que es el caballito de batalla de OpenAI.

Veremos cuánto dura, porque hay varios modelos de varias empresas en camino. Lo que sí puedo decir es que es el modelo que yo estoy usando actualmente y el que nos acompaña en Tres Barbas para el desarrollo de aplicaciones personalizas. Y lo mejor de todo es que se puede usar de forma gratuita acá.

IA en las Redacciones

El Laboratorio de Periodismo publicó en uno de sus últimos newsletters un resumen del Leading Newsrooms in the Age of Generative AI de la Unión Europea de Radiodifusión. Este informe hace una radiografía de la brecha entre el ritmo vertiginoso de la IA y la capacidad de los medios para domarla. Su autora, Alexandra Borchardt, constata que en solo diez meses las herramientas han dado un salto gigante, mientras las redacciones aún calibran riesgos y ventajas. Las entrevistas a líderes de BBC, ZDF, Washington Post, MIT Media Lab o Reuters Institute revelan que, por ahora, la apuesta segura es automatizar tareas repetitivas y liberar tiempo para el criterio periodístico.

Pero la revolución no viene sin alertas. Eric Scherer (France Télévisions/EBU) avisa de que perder el control humano puede dañar la democracia, y por eso la comunidad pública europea exige reglas claras: permiso para usar contenido periodístico, atribución visible y exactitud verificable. Liz Corbin (EBU) remata: la IA solo será aliada si potencia el valor añadido —narrativas sólidas, responsabilidad constante y conexión con la audiencia—, un mensaje que sirve de brújula a quienes quieren innovar sin renunciar a la esencia del oficio.

Claves

- La IA crece a toda velocidad y las redacciones optan por la prudencia para no sacrificar rigor ni confianza.

- Se usa con éxito “puertas adentro” (traducción, transcripción, subtítulos), pero aún se vigila su precisión antes de exponerla al público.

- Seis frentes estratégicos resultan imprescindibles: periodismo, distribución, plataformas, tecnología, datos y talento.

- La supervisión humana sigue siendo innegociable; sin ella, el “escalado mágico” que promete la IA se frena.

- La EBU prepara un código de buenas prácticas que reclama autorización y transparencia a las grandes tecnológicas.

- El periodismo que brille será el que combine IA con historias de calidad, voces genuinas y responsabilidad.

Relámpago

- La Familia de modelo Qwen 3, de Alibaba llegaron para competir con los grandes y con la posibilidad de instalar un modelo de razonamiento en una computadora “normal”. El Qwen3-30B-A3B (se puede instalar con LMStudio) activa solo una parte del modelo y ahorra costo de procesamiento y el Qwen3-235B-A22B compite con los mejores (aunque acá ya queda un poco lejos de una computadora normal). Ideal para usar sin internet o si se corta la luz y tenés batería en la notebook.

- Microsoft presentó nuevos modelos de su familia Phi, con la misma lógica de Qwen para que se puedan ejecutar en dispositivos más “razonables”, incluso teléfonos.

- Anthropic está a full con MCP y ahora puede conectar a Claude con muchas herramientas.

- No solo en el Congreso, ahora los Emiratos Árabes Unidos quieren introducir la IA en los planes de escuelas públicas, desde el jardín de infantes.

- Fuentes indican que China estpa usando DeepSeek para mejorar el desarrollo de sus aviones de guerra.

- Se viene Comet, el navegador de Perplexity con el ojo puesto en competir con Chrome (por lo visto no lo va a comprar).

- “Por favor” y “gracias”, uno de los investigadores de DeepMind de Google indicó que usar lenguaje educado puede mejorar los resultados de la IA.

- También desde DeepMind señalaron que cada vez está más cerca “la ventana de 10 millones de tokens de contexto”.

- El nuevo modelo DeepSeek-Prover-V2 es un avance “revolucionario en inteligencia artificial”, en particular en la automatización del razonamiento matemático formal, dicen sus responsables. En especial para hacer aviones de guerra (?)

- Los usuarios de pago de Suno ya tienen acceso a la versión 4.5 de su modelo de generación de música con inteligencia artificial, agregando nuevos géneros, mejores indicaciones y adherencia, la capacidad de crear canciones de hasta 8 minutos de duración y más.

- Xiaomi presentó MiMo su propio modelo que como todos dice que es el mejor. Veremos qué onda en las próximas semanas.

- El psicólogo IA (?) Therabot mejora sus resultados en tratamientos de salud mental. Ya hablamos de esto y se puede leer acá.

- Meta preparó un modelo de Llama para usar en el espacio y lo tienen en la Estación Espacial Internacional.

- Nvidia lanzó Parakeet V2, un modelo capaz de reconocer, entender y transcribir una hora de audio en un segundo. Según las pruebas el margen de error es de 6,05 %, de los más bajos del mercado.

- Lectura recomendada: Pepe Cerezo publicó una entrada en la que reflexiona sobre IA + buscadores + SEO. ¿La IA va a terminar de matar el modelo de negocio basado en contenido basura para tener clics y mostrar números altos?

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Es algo súper íntimo y pueden no estar de acuerdo, pero creo que es una manera interesante de no solo decir “existe esto” si no “yo lo uso así” (o no).

Texto: mis GPTs personalizados y sino o3 (plan plus), Redacta.Pro (de pago). Para aplicaciones (o sea con API) 4o-mini y algunas con 4.1o.

Video: estoy jugando con algunas, como mencioné arriba, pero nada definitivo.

Audio: Elevenlabs (Pago), Adobe Audition (Pago) y NotebookLM (free).

Imágenes: GPT-4o (Pago) e Ideogram (gratis).

Programación: Gemini 2.5 Pro

Buscador: Deep Research (OpenAI plus) y Perplexity (free).

Música: Suno.