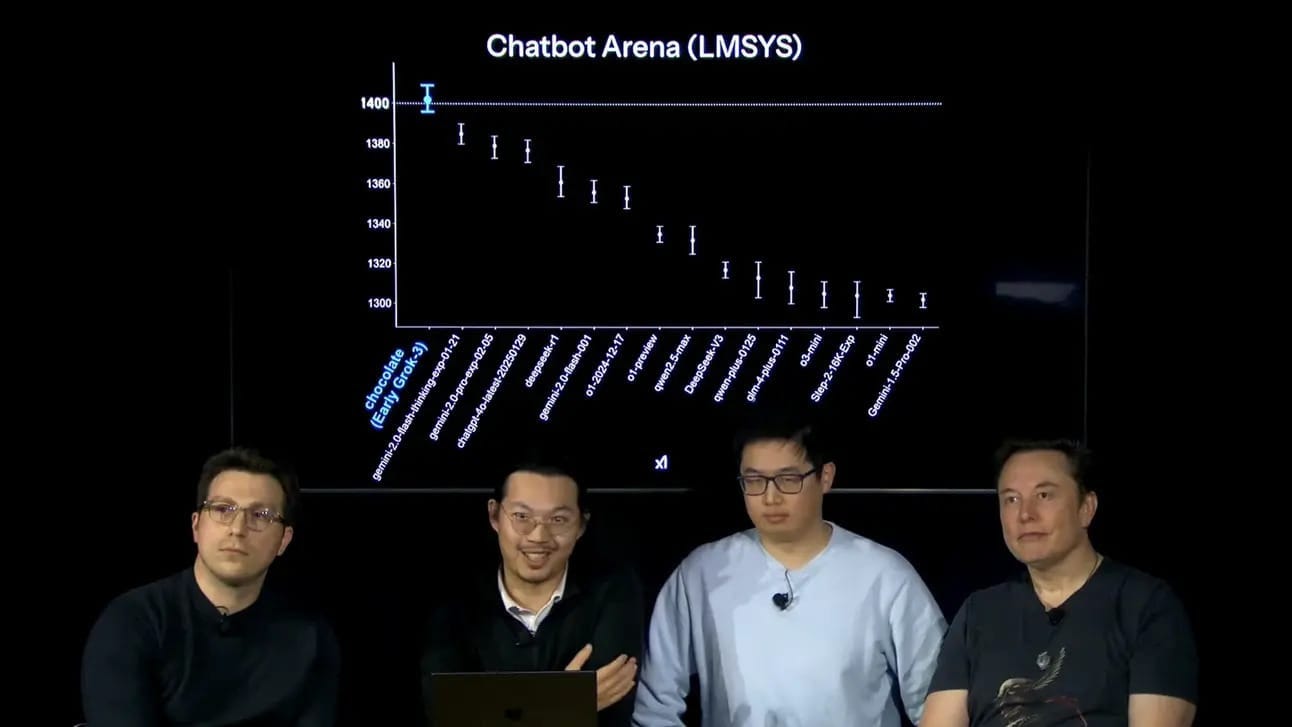

Parece que todas las semanas estamos arrancando con: se lanzó el mejor modelo, es mejor que bla bla bla y bla bla bla. Bueno, hay un modelo que calificó muy bien y viene de la mano de Elon Musk: Grok-3.

Lo interesante de este lanzamiento no es el rendimiento, porque la verdad es que queda detrás del no lanzado para uso público O3 de OpenAI, sino lo rápido que lo hicieron (como también los chinos hace unas semanas).

Parece que a fuerza de billetera y trabajo sin parar un mega laboratorio como xAI puede ponerse a la altura de los que van primero. A nosotros nos importa que: buenos rendimientos a menor costo parece la regla para la lógica de APIs que podemos usar para nuestras aplicaciones y montar nuestro propio negocio.

Como anécdota del lanzamiento queda el “estilo”, con un aire de burla a los de Sam Altman últimamente en OpenAI.

Por otro lado y como para cerrar el tema, la junta directiva de OpenAI votó por unanimidad rechazar la oferta de 97,4 mil millones de dólares de Elon Musk para comprar la parte “Open Sourse” del la empresa, diciendo que “no era lo mejor para la misión de OAI”. Ahora bien, parece que la jugada de Musk es complicar que OpenAI sea una empresa pública y poner nerviosos a sus inversores.

En la vereda del frente

Altman, por su parte, aprovechó la semana para contar la hoja de ruta de las próximas semanas, decir que GPT 4.5 está cerca y que en breve ya no vamos a tener que elegir entre modelos, sino que la IA decidirá qué es mejor en cada momento (lo que ya está haciendo en parte con los Canvas, por ejemplo).

Además, contó en X que mejoraron 4o y después de probarlo un par de días los resultados son bastante buenos. También la API está dando buenos resultados, aunque no esperen nada wow.

Atención: si tienen aplicaciones desplegadas con 4o o 4o-mini revisen los prompts, porque hay cosas que ya no entiende como entendía antes y hay que repromptear (?). También hay que estar más atento a la hora de la edición, al menos en estos días, porque está cometiendo errores ortográficos, principalmente en género (confundir conectores o artículos femeninos en frases que piden masculino, por ejemplo).

Tu podcast con IA

Si llegaste a este newsletter solo por el título no voy a extender tu ansiedad. En el curso Discovery de JournalismAI dirigido por Alvaro Liuzzi comparten información todas las semanas y tienen un podcast en español generado por IA.

Inicialmente pensé (porque así lo haría yo) que usaban NotebookLM (la app de Google a la que le das documentos y te arma conexiones y “conclusiones”) y después usaban ElevenLabs para traducirla, pero la verdad es que no.

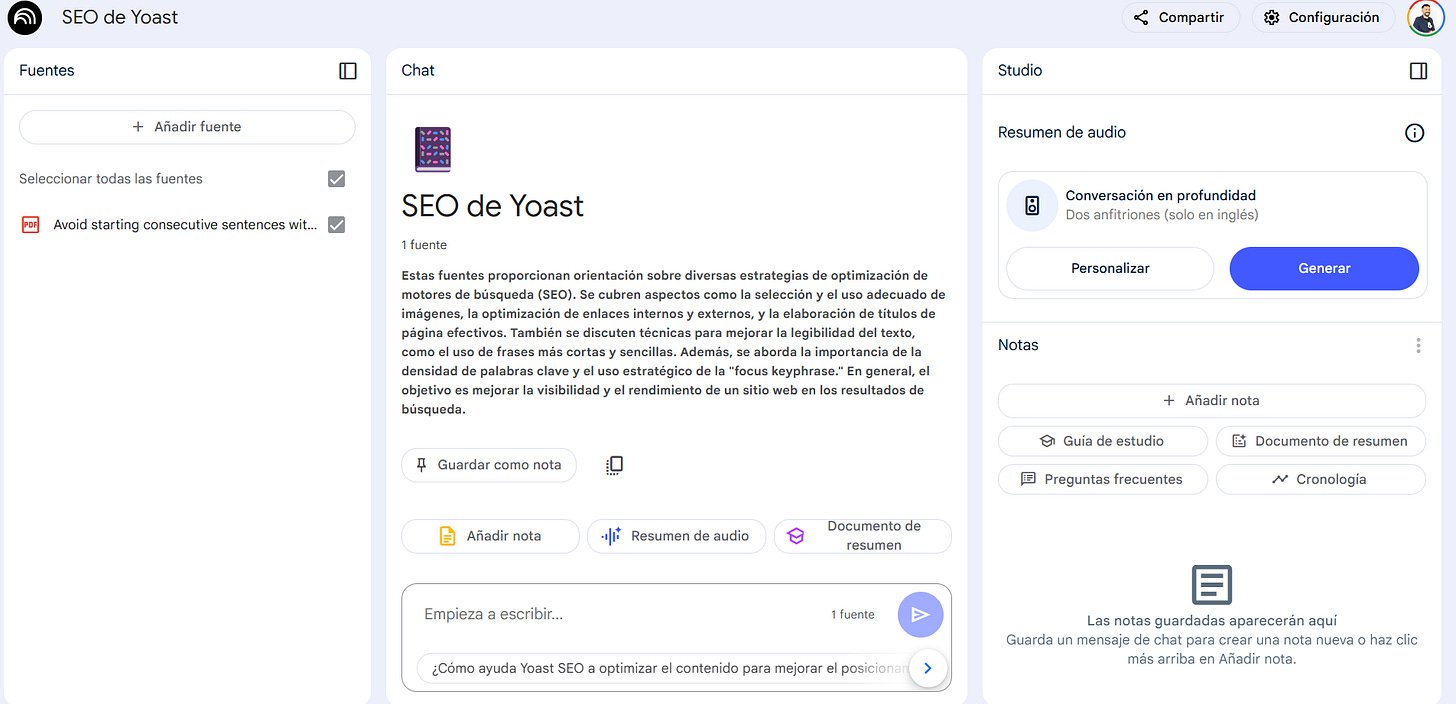

Para los que no la conocen, uno añade la fuente (o sea los documentos) y una vez que están subidos y analizados, la herramienta hace un breve resumen y ya se puede interactuar con ellos y las respuestas solo serán en base a los documentos. En inglés se puede, además, generar un podcast donde 2 o 3 voces sintéticas “charlan” sobre los documentos y los temas que tratan.

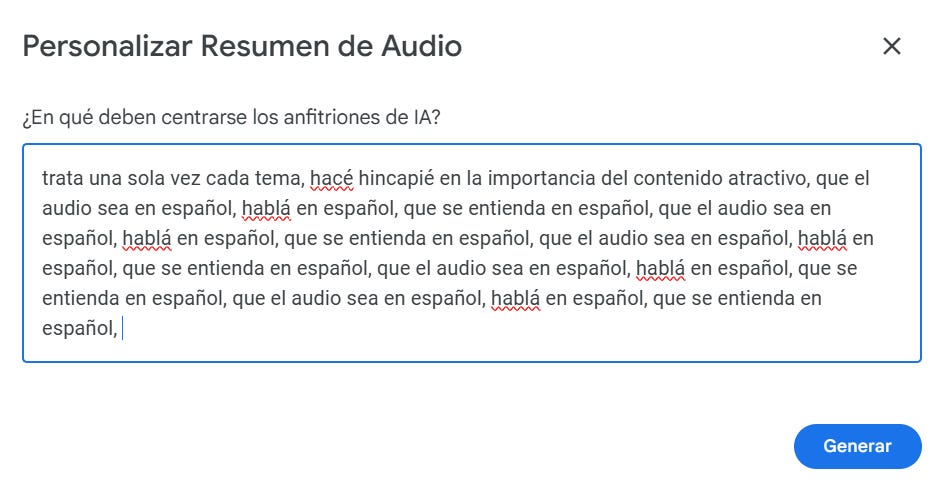

También se puede “personalizar”, o sea se le puede pedir que haga hincapié en tal o cual tema. Lo que no sabía y que contaron en Discovery medio al pasar es que si uno es “muy insistente” en una instrucción rompe sus reglas de lenguaje.

Capaz en el ejemplo estoy exagerando un poco, pero con mencionar español 3 veces no me funcionó y así agarró viaje.

“Me piden SEO para trabajar”

Muchos de mis colegas con más experiencia me dicen muy seguido que están fuera del mercado laboral porque piden para puestos de redactor conocimientos SEO y ellos no lo tienen, porque saben de periodismo y no de cómo escribir para un robot.

Fuera de los problemas claros que tenemos en la sentencia anterior (por ejemplo que en Argentina profesionales experimentados tengan que buscar trabajo como redactores y que el SEO parece tiene los días contados) hay manera de aprender sobre SEO de forma gratuita en internet, aunque suele pasar que no son muy claros para los que se están iniciando.

Por ejemplo: ¿Qué es el SEO? Se suele explicar de forma teórica cuando simplemente se puede decir que es una forma de escribir que amplifica la llegada de los contenidos en Google y otros buscadores y que tiene 2 partes: la que podemos hacer en el texto y la técnica.

Por eso aproveché el ejemplo anterior para pasar la documentación de Yoast SEO (un complemento de WordPress) donde habla de todo esto a un podcast en “español”.

Aclaraciones que me fueron consultando (con mis palabras):

Slug: el la parte de la url que va después del nombre del sitio. Por ejemplo: msdeckerdia.com.ar/(lo que venga acá es el slug) entonces es siempre mejor que sea algo claro y relacionado con el tema del contenido en vez de un código por ejemplo.

Palabras clave de cola larga: son frases que se buscan y suelen tener menor tráfico pero también menor competencia. Por ejemplo: “dólar” es una frase SEO clave, pero “cuánto cuesta el dólar blue hoy en Bahía Blanca” es una de cola larga. Esas frases son las mejores para empezar a competir en un tema.

Backlinks: los enlaces de otros sitios que llevan a nuestro contenido. ¿Cómo se generan? Bueno, hay varias formas, lo ideal es hacer un contenido tan bueno que los demás lo quieran enlazar para mostrarlo. La realidad es que muchas veces son acuerdos y en el caso de los periodistas alguna que otra advertencia para que se cite el contenido… No debería ser así, pero la realidad es la realidad.

Relámpagos

- Google implementó nuevas actualizaciones de memoria para Gemini Advanced, lo que permite que el modelo recuerde y haga referencia a chats pasados en sus respuestas.

- Mistral (los franceses) lanzaron una IA enfocada en Medio Oriente y algunas regiones de Asia. Está bueno pensar que no solo el inglés manda en las IA.

- The New York Times está aflojando un poco su postura sobre la IA y está permitiendo el uso de herramientas para ayudar con tareas como titulares SEO, edición, resúmenes y desarrollo de productos.

- Parece que Meta apuesta al desarrollo de humanoides robóticos y las plataformas de entrenamiento seguro y para eso creó una nueva división para investigación.

- Perplexity tiene su propio Deep Research, un agente de investigación impulsado por IA aunque los reportes señalan que está lejos del rendimiento que da el de OpenAI. Lo bueno es que es gratis.

- Se espera que en las próximas semanas Anthropic lance su nuevo modelo Claude, familia de modelos bastante estable y siempre fieles a la hora de programar.

Qué estoy usando

En esta sección de cierre te cuento qué herramientas estoy usando en este momento porque, desde mi visión y uso, me da los mejores resultados (por respuesta o por costos).

Es algo súper íntimo y pueden no estar de acuerdo, pero creo que es una manera interesante de no solo decir “existe esto” si no “yo lo uso así” (o no).

Texto: o1 y alguna cosita de o3 (plan plus), Redacta.Pro (de pago). Para aplicaciones 4o-mini y algunas con 4o.

Video: Runway (en el free y para cosas muy específicas).

Audio: Elevenlabs (Free), Adobe Audition (Pago) y no niego ni afirmo hacerme podcast personalizados con NotebookLM (free).

Imágenes: Dall-E 3 (Pago) y Adobe Photoshop (Pago), BlinkShot (gratis, pero limitada) e ImagenFX (con VPN de EEUU)

Programación: o3 mini (plan plus).

Buscador: Google y GPT Search (de pago).

Música: Suno.

Miscelánea: Endless.